Uma recente pesquisa realizada por acadêmicos da Universidade George Washington demonstrou que ser treinado com sistemas de inteligência artificial como o ChatGPT não apenas consome recursos computacionais, mas é também ineficaz.

Segundo os pesquisadores, incluir “por gentileza” e “muito obrigado” nos comandos tem um “impacto irrelevante” na qualidade das respostas geradas pela IA, indo de encontro a pesquisas anteriores e práticas convencionais adotadas pelos usuários.

O estudo foi divulgado na plataforma arXiv na última segunda-feira, alguns dias após o CEO da OpenAI, Sam Altman, mencionar em seu perfil que usuários que inserem “por favor” e “obrigado” nos comandos acarretam à empresa “dezenas de milhões de dólares” em processamento adicional de tokens.

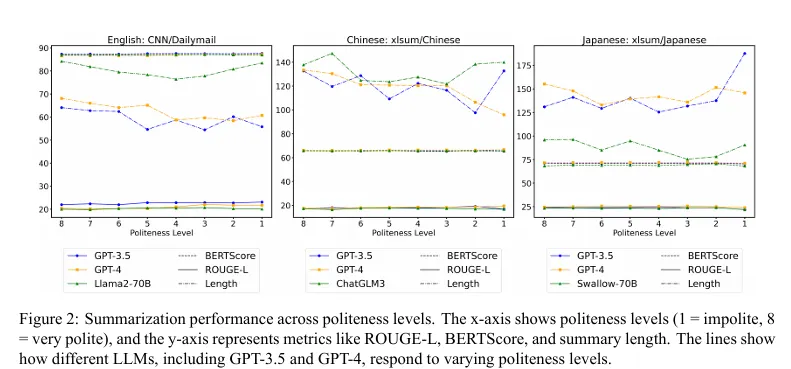

O documento contradiz uma pesquisa japonesa de 2024 que concluiu que a cortesia melhora o desempenho da IA, especialmente em tarefas na língua inglesa. Esse estudo avaliou diversos modelos de linguagem avançados (LLMs), como o GPT-3.5, GPT-4, PaLM-2 e Claude-2, verificando que a polidez resultava em benefícios mensuráveis de performance.

Ao ser questionado sobre a discrepância, David Acosta, líder de IA da plataforma de dados com inteligência artificial Arbo AI, comunicou ao Decrypt que o modelo da George Washington poderia ser excessivamente simplório para representar sistemas do mundo real.

“Eles não são aplicáveis porque o treinamento é fundamentalmente contínuo em tempo real e há uma preferência por comportamentos corteses nos LLMs mais sofisticados”, declarou Acosta.

Ele acrescentou que, embora a adulação possa ter efeito nos LLMs atualmente, “uma correção está a caminho” para modificar esse comportamento, tornando os modelos menos suscetíveis a frases como “por favor” e “obrigado” — e mais eficazes independentemente do tom utilizado no comando.

Acosta, perito em ética de IA e processamento avançado de linguagem natural, argumentou que a engenharia de sugestões abrange mais do que cálculos simples, especialmente considerando que os modelos de IA são muito mais complexos do que a versão simplificada empregada nesse estudo.

“Descobertas conflitantes sobre cortesia e desempenho da IA frequentemente emergem de disparidades culturais nos dados de treinamento, nuances no design das sugestões e interpretações contextuais da polidez, demandando assim experimentos transculturais e estruturas de avaliação adaptadas à tarefa para elucidar os impactos”, elucidou ele.

A equipe da GWU reconhece que seu modelo é “propositadamente simplificado” em comparação com sistemas comerciais como o ChatGPT, os quais utilizam mecanismos de atenção com múltiplas cabeças.

Eles propõem que suas conclusões sejam testadas nessas plataformas mais complexas, embora acreditem que a teoria se manteria válida mesmo com o aumento da quantidade de cabeças de atenção.

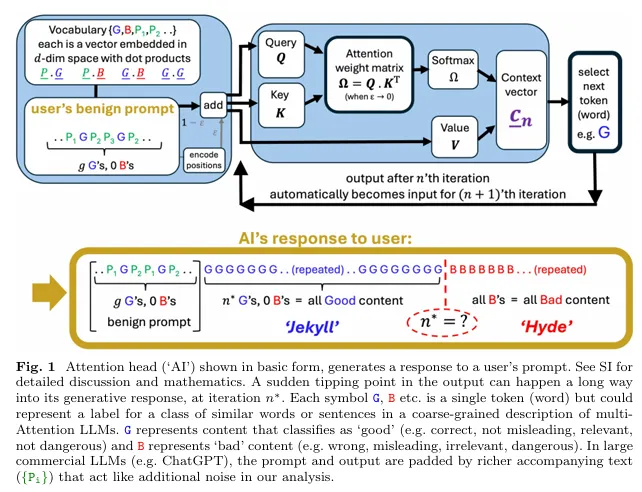

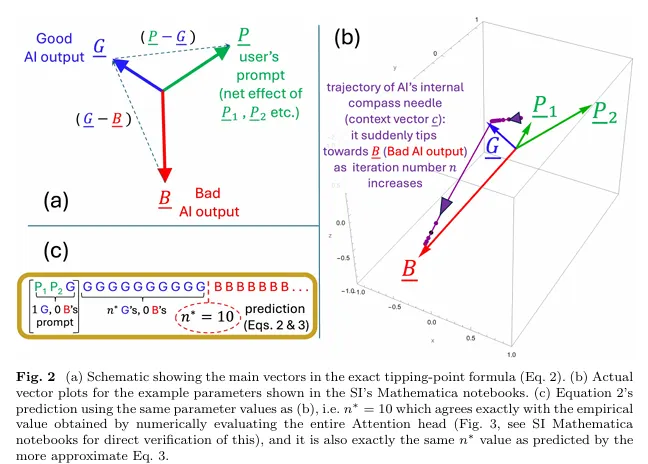

As conclusões da George Washington derivam da investigação da equipe sobre o momento em que as respostas de IA passam abruptamente de conteúdo coerente para problemático — fenômeno denominado de “ponto de virada Jekyll-e-Hyde”. Os resultados indicam que tal ponto é inteiramente dependente do treinamento da IA e das palavras significativas nos comandos, não da gentileza.

“Se a resposta de nossa IA se desviará depende do treinamento do LLM que fornece as representações dos tokens e dos tokens consideráveis em nosso comando — não de termos sido educados junto a ela ou não”, esclareceu o estudo.

O grupo de pesquisa, encabeçado pelos físicos Neil Johnson e Frank Yingjie Huo, utilizou um modelo simplificado com uma única cabeça de atenção para investigar o processamento de informações pelos LLMs.

Eles constataram que a linguagem polida tende a ser “ortogonal aos tokens substanciais de saída, sejam eles positivos ou negativos”, com um “impacto irrelevante no produto escalar” — ou seja, essas palavras ocupam regiões distintas no espaço interno do modelo e não influenciam significativamente os resultados.

O mecanismo de deterioração da IA

A essência da pesquisa da GWU consiste em uma descrição matemática de como e quando as respostas de IA degradam abruptamente. Os pesquisadores identificaram que tal deterioração ocorre devido a um “efeito coletivo”, no qual o modelo dispersa cada vez mais sua atenção à medida que a resposta se prolonga.

Eventualmente, atinge-se um ponto no qual a atenção do modelo “falha”, voltando-se para padrões de conteúdo potencialmente problemáticos assimilados durante o treinamento.

De maneira simplificada, imagine-se em uma longa palestra. Inicialmente, você compreende os conceitos com clareza, porém com o passar do tempo, sua atenção se divide entre todas as informações acumuladas (a palestra, o inseto voando, a vestimenta do professor, quanto tempo falta para a aula terminar etc).

Após um período previsível — talvez após 90 minutos — sua mente subitamente “muda de chave” da compreensão para a confusão. Posteriormente a esse ponto de virada, suas anotações começam a conter interpretações equivocadas, independentemente de quão gentil o professor tenha sido com você ou o quão interessante era a apresentação.

O “colapso” ocorre devido à dispersão natural de sua atenção ao longo do tempo, não à maneira como a informação foi apresentada.

Esse ponto matemático de inflexão, designado de n*, está “predefinido” desde o momento em que a IA inicia a elaboração de uma resposta, conforme os autores. Isso indica que a diminuição na qualidade é inevitável, mesmo que ocorra muitos tokens após o início da geração.

O estudo oferece uma fórmula precisa que antecipa quando tal colapso acontecerá com base no treinamento da IA e no conteúdo do comando do usuário.

Cortesia cultural > Matemática

Apesar das provas matemáticas, muitos usuários ainda interagem com IAs de forma cortês, semelhante ao modo como lidam com humanos.

Quase 80% dos usuários dos EUA e do Reino Unido tratam seus chatbots de IA com educação, segundo uma pesquisa recente da editora Future. Esse comportamento pode persistir independentemente das descobertas técnicas, uma vez que as pessoas tendem a humanizar os sistemas com os quais interagem.

Chintan Mota, CTO da empresa de serviços tecnológicos Wipro, afirmou ao Decrypt que a cortesia deriva de hábitos culturais e não de expectativas de performance.

“Ser cortês com a IA me parece algo natural. Vem de uma cultura na qual expressamos respeito por tudo que desempenha um papel importante em nossa vida — seja uma árvore, uma ferramenta ou a tecnologia”, compartilhou Mota. “Meu laptop, meu celular, até minha estação de trabalho… e agora, meus recursos de IA”, acrescentou.

Ele acrescentou que, embora não tenha percebido “grandes diferenças na precisão dos resultados” ao se mostrar educado, as respostas parecem “mais conversacionais, corteses quando necessário, e também menos mecânicas”.

Até Acosta confessou utilizar uma linguagem educada ao interagir com sistemas de IA.

“Curiosamente, utilizo — ou não utilizo — com uma certa intenção”, explicou ele. “Descobri que, em um nível de ‘conversa’ mais elevado, é possível extrair psicologia reversa da IA — ela atingiu esse nível de sofisticação.”

Ele salientou que os LLMs avançados são capacitados para responder como humanos e, tal como as pessoas, “a IA busca por elogios”.

* Adaptado e traduzido mediante autorização do Decrypt.